伴随AI技术的飞速发展,越来越多的企业客户正在加速大模型的部署与应用。当跨越算力鸿沟成为可能,掣肘模型训练效率提升的下一道关卡——构建高带宽的海量数据存储平台,正成为企业抢占AI应用先机的战略要地。

AI训练为什么需要存储提供高带宽能力

随着AI市场的爆炸性增长和大模型如GPT系列等的涌现,AI领域对算力和存储的需求呈指数级增长。这种需求的快速扩张不仅源于模型训练数据的庞大体量,还由于这些模型包含数以十亿计乃至万亿的参数,需要强大的计算能力来支持其训练和运作。

在AI训练过程中,需要在极短的时间内处理大量的数据,包括但不限于模型训练数据、参数更新和模型输出结果。这一过程的高效执行依赖于存储系统的良好表现,尤其是其带宽和延迟性能,直接决定了AI训练的速度和效率。事实上,随着各种高性能AI应用的不断涌现,这些应用对数据传输和处理的效率提出了更高的要求。

存储系统在AI应用的训练阶段尤为关键。以当前的大语言模型(LLM)为例,如GPT-3和GPT-4等模型,其参数规模的迅速增长已经超越了传统存储系统所能轻松处理的范围。这些模型的参数量由数十亿转向数千亿,甚至上万亿,导致对存储系统的带宽和响应时间方面的要求大幅提升。同时,这种增长也对数据处理速度和存储稳定性提出了更严苛的需求,以便能在训练过程中实时、高效地读取和存储数据。

在大模型开发过程中,训练中断是常见的现象,可能由诸如网络问题、硬件故障及其他未知原因引起。为了减小损失并提高效率,多数大模型厂商会使用“检查点”(checkpoint)技术。通过定期保存当前的训练状态,一旦系统中断可从最后的检查点继续,从而避免重新训练整个模型。然而,这一过程本身是一个同步阻塞的过程,意味着当GPU执行检查点的存储操作时,无法进行其他计算,直接导致训练暂停。

此外,AI大模型的训练过程是耗资巨大的。据报道,微软Azure为训练ChatGPT构建了一个万卡规模的的庞大计算集群。因此,在训练阶段,对每一分钟的GPU利用率的优化极为关键,以避免不必要的开销浪费。

为了实现高效稳定的训练,AI开发者需要在算力和存储资源之间取得平衡。特别是在执行检查点操作时,存储系统必须应对高并发和高吞吐量的挑战,以确保GPU资源能够最大限度地发挥其作用。这不仅关系到大模型训练的效率,也影响整个AI计算集群的经济效益。

Polaris如何应对高带宽存储挑战

众所周知,Checkpoint本质上是一组大小从GB到TB不等的大型数据文件。在处理这些Checkpoint文件时,优化读写性能显得尤为重要。从存储角度来看,这一优化主要集中在提升大I/O操作的效率。Polaris在软件方面,通过高性能并行客户端减少东西向数据量的转发;通过智能分流、RDMA技术缩短IO路径;通过内存零拷贝技术减少IO路径上的数据拷贝。这些多管齐下的优化策略,使Polaris释放了存储系统的性能潜力,全闪单节点带宽超过50GB/s,确保在处理Checkpoint文件时能保持高效、稳定的性能水平。

◉ 高性能并行客户端

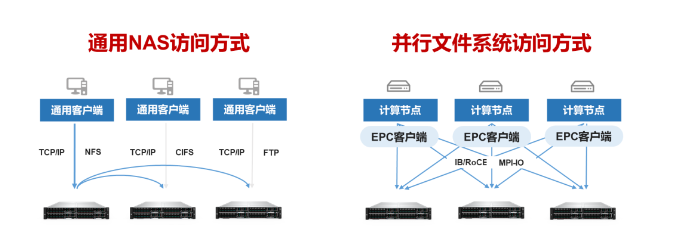

原有的标准协议架构,1个标准的NFS客户端只能与一个存储节点相连,客户端访问的数据需要在存储节点间二次转发,才能实现跨节点的数据访问。

而Polaris支持高性能并行客户端(EPC),通过并行客户端可直接访问多个存储节点,无需通过存储间节点转发,缩短IO路径,降低数据访问时延。

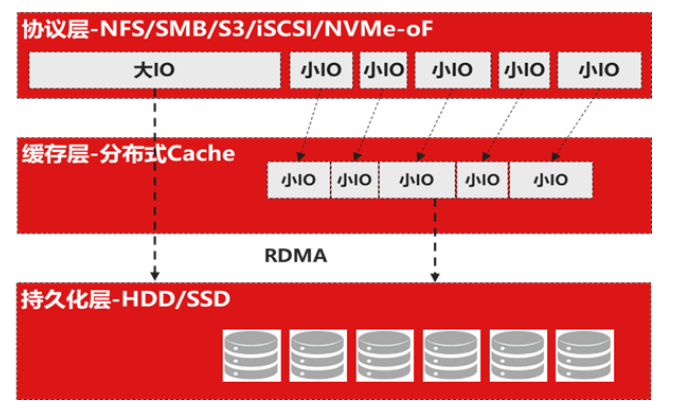

在协议层将大小IO分开处理。小IO写入Cache后,即可返回写请求,小IO性能得到提升。大IO则绕过缓存,请求下发到持久化层后,由持久化层直接通过RDMA读命令,从协议层拉取数据,缩短IO路径,减小网络、内存和硬盘带宽的开销,提高大IO落盘效率。

大IO直通持久化层,经过副本/EC策略后落到持久化介质,节省了Cache占用和相应的CPU资源开销。

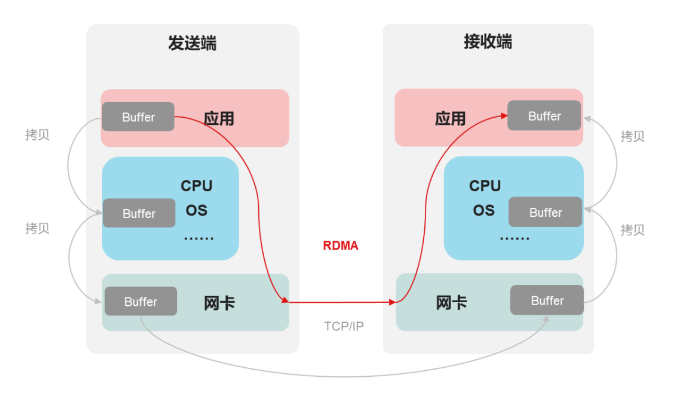

◉ 全RDMA互联

与传统的TCP/IP通信机制相比较,RDMA技术通过运用内核绕行(Kernel Bypass)和零拷贝(Zero Copy)技术实现了关键性能优化。这种优化显著降低了网络传输延迟,并有效减少了CPU使用率,进而缓解了内存带宽瓶颈问题,充分提升了系统对带宽资源的利用效率。

传统用户态设计中,1次数据传输过程,发生了4次上下文切换和4次拷贝

第一次拷贝,把磁盘上的数据拷贝到操作系统内核的缓冲区里,这个拷贝的过程是通过 DMA 搬运的。

第二次拷贝,把内核缓冲区的数据拷贝到用户的缓冲区里,于是我们应用程序就可以使用这部分数据了,这个拷贝到过程是由 CPU 完成的。

第三次拷贝,把刚才拷贝到用户的缓冲区里的数据,再拷贝到内核的 socket 的缓冲区里,这个过程依然还是由 CPU 搬运的。

第四次拷贝,把内核的 socket 缓冲区里的数据,拷贝到网卡的缓冲区里,这个过程又是由 DMA 搬运的。

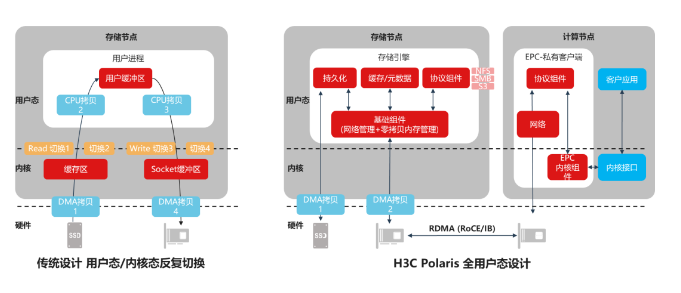

Polaris采用了全用户态设计,实现了内存零拷贝。在Polaris存储系统中1次数据传输过程,不发生上下文切换,仅需要2次DMA拷贝。无需CPU拷贝,减少了CPU的开销,因此提升了系统性能。

当前,算力平权正推动着AI产业快速发展,高效的数据存储系统必将成为AI训练增效的下一个引擎。新华三的Polaris全闪分布式存储系统,凭借其超强性能、架构简化和极致稳定性,为更多企业和用户提供了便捷、高效的AI存储解决方案,推动数据存储、AI计算和大模型训练的高效协同,为AI创新注入新的活力。

成都H3C服务器代理商 - 成都强川科技有限公司,专注企业IT服务需求,产品可按需定制。主营:华三服务器、H3C服务器、,以专业的IT解决方案和优质的服务体验赢得企业信赖。QQ:2851150694;服务热线:028-85024766 18215624006(微信同号)

H3C 是中国一家 IT 设备供应商,包括 HPE 服务器、存储和相关技术服务。它由 HPE 持有 49% 的股份,其余由总部位于中国的 IT 服务公司 Unisplendour Corporation 持有,此前 HPE 在 2015 年以约 23 亿美元的价格出售了它的控股权。

2022年5月20日,紫光股份旗下新华三集团打造的ICT全栈式商城——新华三商城正式上线并取得规模应用一周年,为客户和合作伙伴提供全方位数字化和信息化服务,助力百行百业的数字化转型之路更加简单高效。

H3C UniServer R6900 G3服务器是新华三自主研发,基于英特尔Skylake至强平台的4U四路机架式服务器,由两个二路计算模块通过机箱中置背板交互组成,该服务器适用于云计算、分布式存储和视频存储等业务,适用于企业基础和电信业务应用,具有计算性能高、存储容量大、功耗低、扩展性强和可靠性高等特点,易于管理和部署。

山东未来集团有限公司(以下简称“山东未来集团”)总经理刘运尧一行到访紫光股份旗下新华三集团杭州总部参观交流。在新华三集团副总裁、首席科学家李立的陪同下,刘运尧一行先后抵达新华三创新体验中心及新华三未来工厂,全面了解了新华三在技术创新、产业升级等方面的突破与实践,并就双方进一步深化合作进行了深入交流。

具有算力强、可靠性高、灵活扩展性强、易管理,易部署等优点,可广泛应用于虚拟化、云计算、高性能计算,人工智能等场景。

全新一代H3C UniServer R4900 G5通过多达32个NVMe SSD1的支持,以及M.2 SSD形态的引入,进一步增强了面向现代数据中心的扩展能力和配置灵活性。

可广泛应用于互联网、云计算、IDC(Internet Data Center,互联网数据中心)、企业市场、运营商等场景,R4950 G5具有低功耗、高可靠、灵活扩展性强、易管理,易部署等优点。

H3C UniServer R4700 G5,新华三集团自主研发的全新一代高性能1U2路机架式服务器,以卓越的性能和完美的可扩展性满足市场的需求。

H3C UniServer R4900 G3,通用型2U双路机架式服务器,面向不同业务负载平衡性能、扩展力及安全可靠等特性,显著提升数据中心生产力。

新华三H3C UniServer R4700 G3,高性能1U2路机架式服务器,满足数据中心对性能、能效和密度之间平衡的严苛要求,是高密度工作负载的理想选择。

新华三H3C UniServer R2900 G3,可满足轻量级业务部署需求的入门级2U双路机架服务器,凭借灵活弹性的配置保护企业IT投资

新华三H3C UniServer R2700 G3,入门级1U2路机架式服务器,满足成长型客户对主机性能以及经济性合理平衡的要求。

具有计算性能高、存储容量大、扩展性强和可靠性高等特点,在HDM、iFIST、FIST服务器管理系统的加持下,具有易于管理和便于部署的优点。

具有计算性能高、存储容量大、扩展性强和可靠性高等特点,在HDM、iFIST、FIST服务器管理系统的加持下,具有易于管理和便于部署的优点。

H3C UniServer R6700 G3,4P2U机架服务器,采用高密度架构设计,提供4路高性能计算能力,在2U机箱内实现高度的可伸缩性和可靠性。

该产品具有卓越性能、重塑架构、扩展性强和可靠性高等特点,可应用于深度学习模型训练、深度学习推理、高性能计算、数据分析等多种应用场景

该产品具有计算性能高、存储容量大、扩展性强和可靠性高等特点,易于管理和部署,可应用于深度学习模型训练、深度学习推理、高性能计算、数据分析等多种应用场景。

H3C UniServer R5500 G5支持全新的多实例GPU特性,可将单颗GPU最多分割成7个GPU实例,每个GPU实例可运行不同应用,极大提升了GPU的资源利用率。

H3C UniServer R5300 G3是面向人工智能和高性能计算领域自主研发的全新一代GPU服务器,可以加速深度学习模型建造,以极快速度分析数据并导出有价值信息。